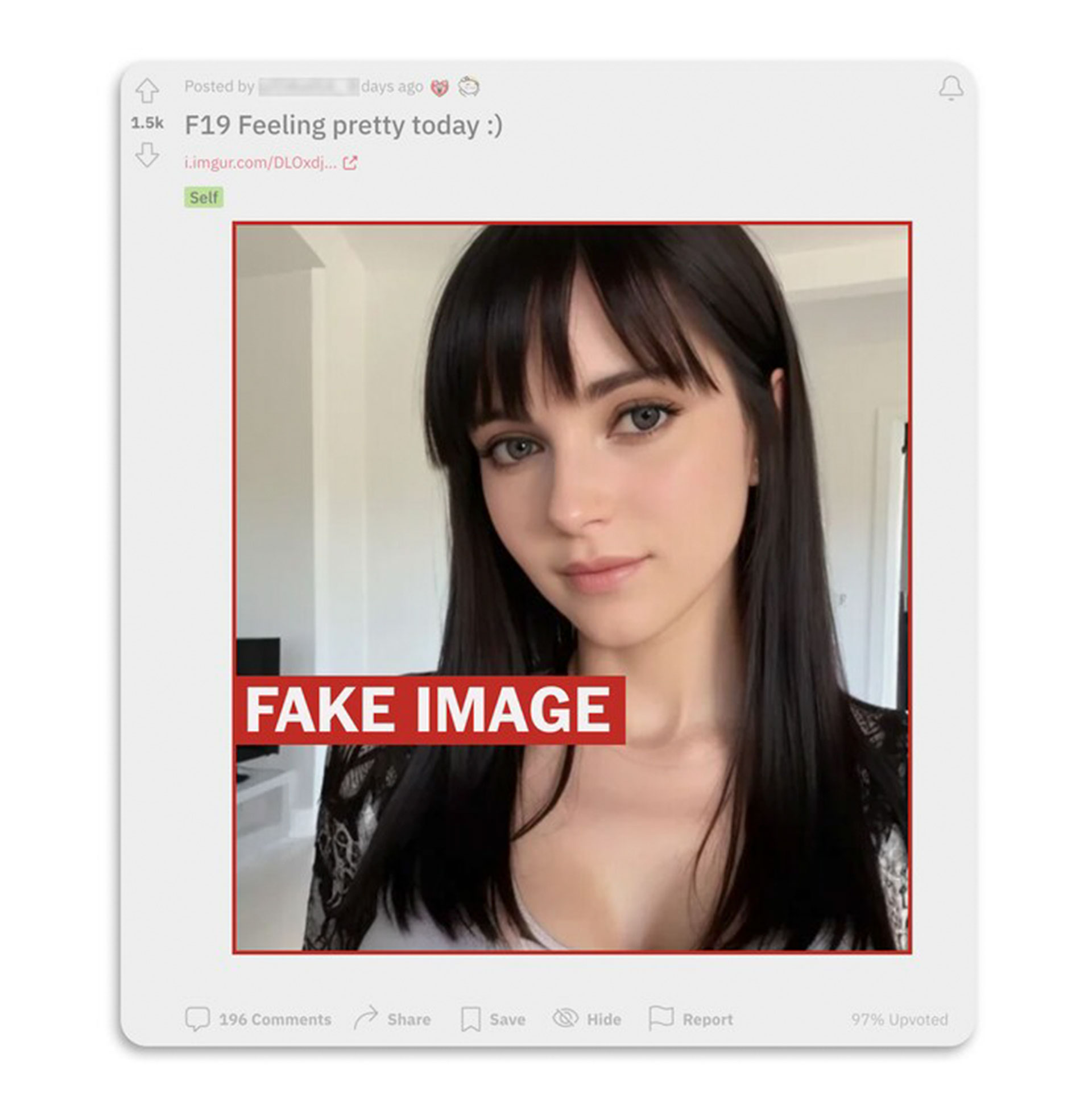

La foto muestra el rostro de una joven de pelo largo y oscuro y sonrisa suave que dice “sentirse guapa hoy :)”. Y en Reddit -donde Claudia, que así se llama, se ofrece a vender fotos de desnudos a cualquiera que le envíe un mensaje privado- es bastante popular: “Joder, eres preciosa”, decía un usuario.

Pero Claudia es falsa: un conjunto de fotos sorprendentemente convincentes creadas por herramientas de imagen de inteligencia artificial, posiblemente para sacar dinero a compradores desprevenidos, según dos investigadores de medios sintéticos.

Los rápidos avances de los generadores de imágenes de inteligencia artificial, como Midjourney y Stable Diffusion, han acaparado la atención mundial en las últimas semanas por sus ingeniosas obras de arte e impresionantes falsificaciones de ex presidentes y papas.

Pero el caso de Claudia deja entrever el lado más explícito de la tecnología: al permitir a cualquiera crear imágenes de personas falsas que parecen increíblemente reales, estas herramientas están cambiando la forma de hacer y consumir material para adultos.

Durante años, las nuevas tecnologías han sido pioneras a través del contenido condicionado, y las herramientas de imagen por IA no han roto ese patrón. Actualmente hay miles de cuentas registradas en foros de debate y salas de chat dedicadas a la creación y el perfeccionamiento de personas sintéticas, la mayoría de las cuales se parecen a niñas y mujeres, un rápido cambio que podría poner patas arriba una industria multimillonaria, socavar la demanda de modelos y actores del mundo real y alimentar preocupaciones más profundas sobre la cosificación y la explotación de la mujer.

La cuenta de Claudia no respondió a las peticiones de comentarios, por lo que es imposible confirmar cómo se hicieron las fotos o cuánto dinero se recaudó con el engaño de hace meses.

Sin embargo, según los investigadores, las fotos presentaban varias características claras de falsedad, como detalles extraños en el fondo y un lunar en el cuello que desaparecía entre una pose y otra. “En realidad, eran bastante fáciles de crear”, dijo un programador de IA.

Los investigadores identificaron varios perfiles en línea de mujeres que creen que son avatares falsos basándose en los artefactos reveladores que algunos generadores de imágenes de IA dejan tras de sí. A través de perfiles en Instagram, Reddit, Twitter y OnlyFans, las cuentas compartían imágenes de mujeres en distintos estados de desnudez e indicaban a los espectadores que debían pagar o suscribirse si querían ver más.

Las presuntas cuentas falsas no respondieron a las preguntas. Y como la mayoría de las imágenes generadas por IA no llevan marca de agua ni huella digital alguna en el momento de su creación, puede resultar difícil para cualquier espectador confirmar si son reales o no.

Cientos de cuentas en línea siguieron y comentaron las cuentas falsas, dejando comentarios que sugerían que creían que las mujeres eran reales.

“Me siento un poco engañado”, dijo el usuario de Reddit “legalbeagle1966″ después de que un periodista del Washington Post le dijera que Claudia era probablemente un fraude. Una semana antes, había comentado en su foto que parecía “bastante sexy y perfecta”.

Muchas de las imágenes falsas más recientes se basan en programas de inteligencia artificial, conocidos como modelos de difusión, que permiten a cualquiera teclear una breve retahíla de palabras y crear una foto falsa de forma gratuita. A continuación, las imágenes pueden editarse aún más para hacerlas más convincentes, incluso para tapar fallos y perfeccionar su calidad.

Las herramientas son incluso más fáciles de usar que el software de “deepfake” que alimentó las preocupaciones sobre las imágenes de IA en 2017. Mientras que los deepfakes utilizaban técnicas de IA de aprendizaje profundo para editar vídeos existentes, los modelos de difusión generan fotos completamente nuevas siguiendo los patrones encontrados en los miles de millones de imágenes que han analizado anteriormente.